Geminiを基本設定のまま使うと、あなたのチャット内容が学習データとして使用される可能性があります。

Geminiに学習させないよう設定したい場合、以下の手順で設定を変更位してください。

- geminiの右上にあるプロフィールアイコンをクリック

- 表示内容から「Gemini アプリ アクティビティ」をクリック

- 「Gemini アプリ アクティビティ」欄の「オフにする」をクリック

- geminiの左下にある「設定とヘルプ」をクリック

- 表示内容から「アクティビティ」をクリック

- 「Gemini アプリ アクティビティ」欄の「オフにする」をクリック

本記事ではGeminiの学習機能をオフにする方法を実際の画像を交えて詳しく解説します。

また、Geminiに学習させないように設定するメリットや注意点についても紹介しているので、どちらが良いのか迷っている方は参考にしてみて下さい。

Geminiで入力データをAI学習から除外する手順

Google Geminiのチャット内容を学習させない方法を、ブラウザ向けとアプリ向け、Workspace管理者向けに解説します。

ブラウザでGeminiのチャット内容を学習させない方法

はじめにGeminiをブラウザで開きます。

Gemini:https://gemini.google.com/app?hl=ja

表示内容の左下にある「設定とヘルプ」をクリックし、表示内容から「アクティビティ」をクリックします。

「Gemini アプリ アクティビティ」欄にある「オフにする」をクリックします。すると以下の選択肢が出てくるので、希望する方をくりっくしてください。

- オフにする:AIの学習をオフにする機能のみ実行

- オフにしてアクティビティを削除:AIの学習をオフにして、過去の履歴も削除する。

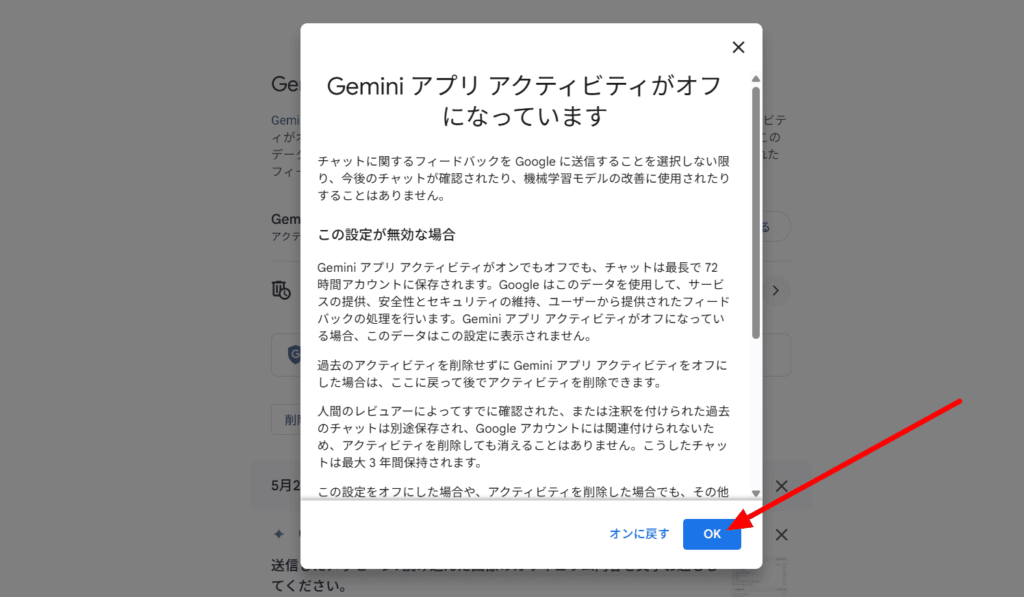

上記画面が表示されるので、スクロールして「OK」をクリックして完了です。

Geminiのチャット画面に戻ると、左の履歴が非表示になっています。このように、Geminiの学習をオフにすると履歴が更新されない仕様になるのが特徴です。

Geminiアプリのチャット内容を学習させない方法

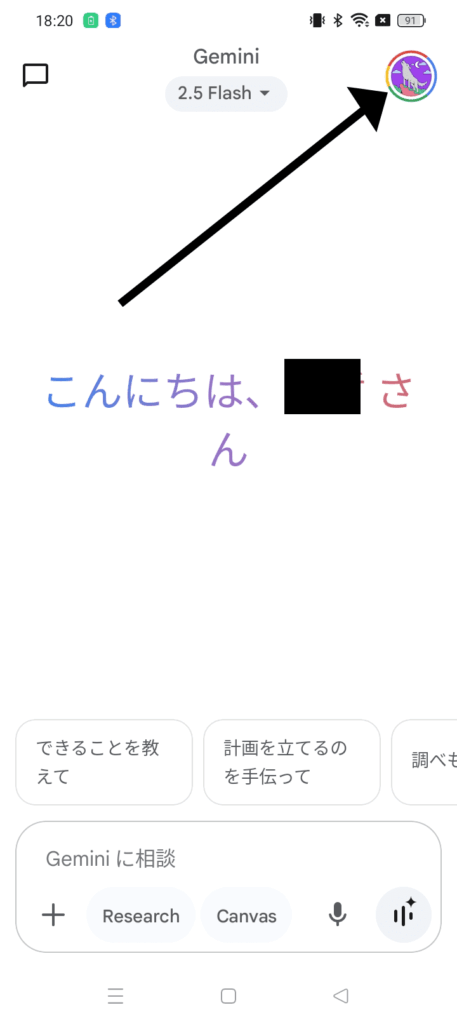

はじめにGeminiのアプリを開き、右上にあるプロフィールアイコンをクリックします。

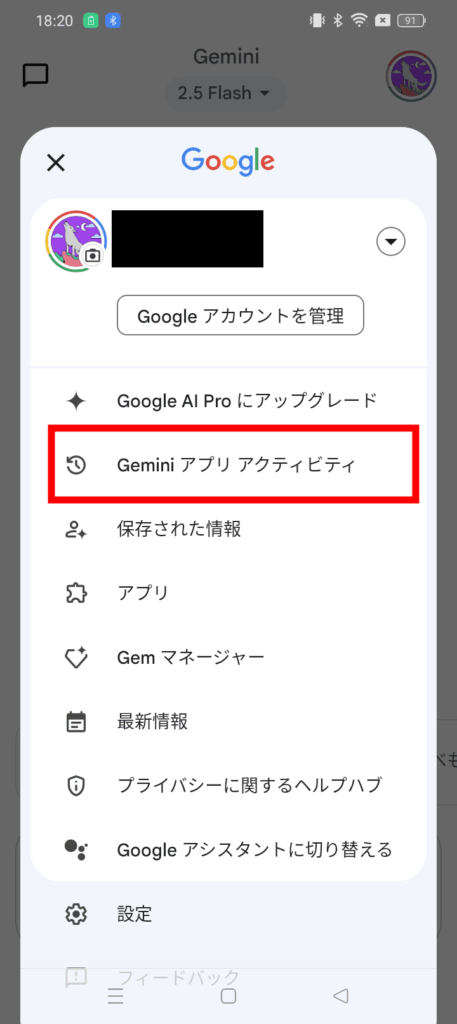

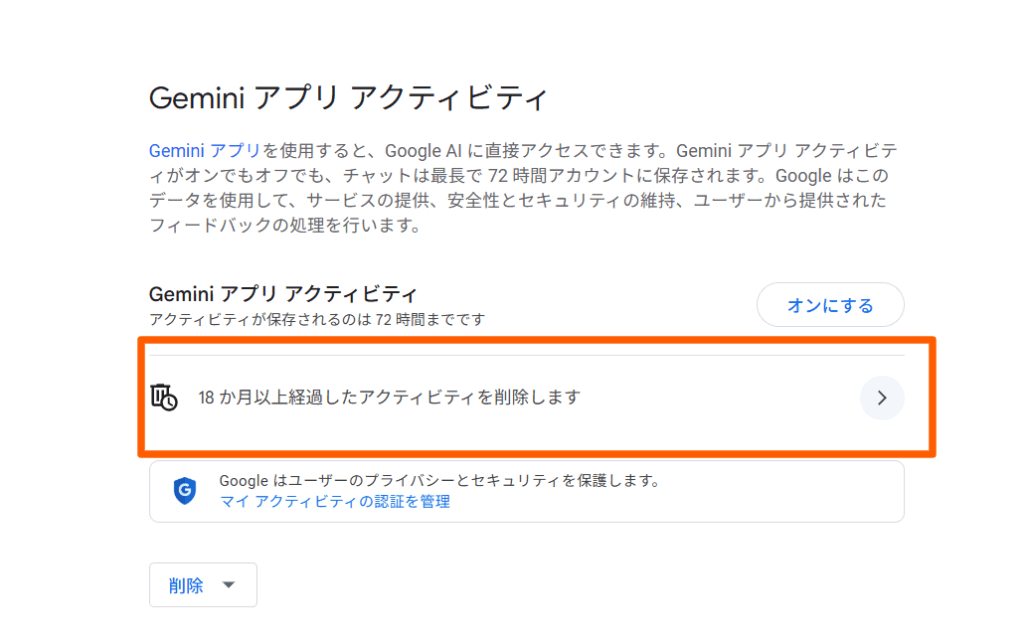

表示内容から「Gemini アプリ アクティビティ」をクリック

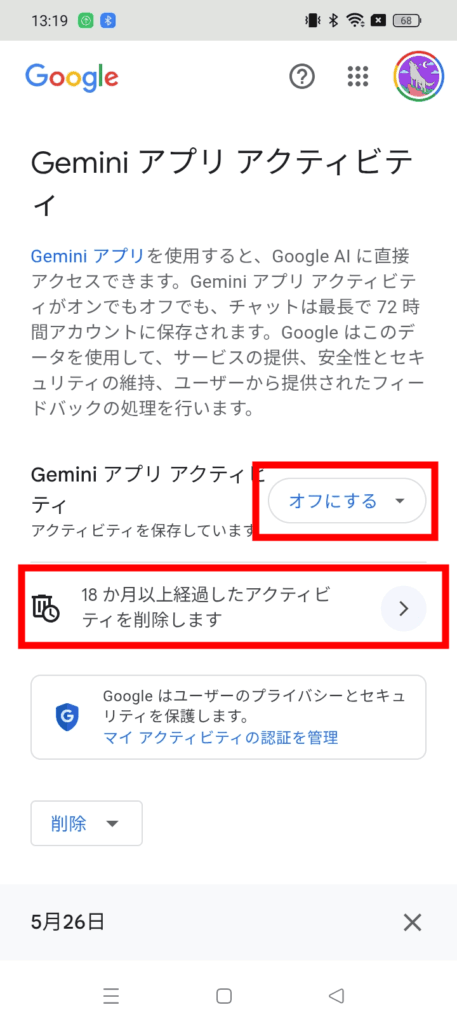

「Gemini アプリ アクティビティ」欄の「オフにする」をクリックすることで、Geminiが学習できないよう設定できます。

また、下部にある「18ヶ月以上経過したアクティビティを削除します。」という欄は、Geminiに入力したチャットの保存期間を指します。

こちらをクリックすることで、保存期間を最短3ヶ月、最長24か月に変更できます。

Workspace管理者がGeminiのチャット内容を学習させない方法

Workspace管理者がGeminiのチャット内容を学習させない設定は以下の手順で行います。

- Workspace管理者の場合は管理コンソールを開く

- Admin Consoleをクリック

- Generative AIをクリック

- Gemini appをクリック

- Conversation historyをクリック

- 組織単位で「保存する/しない」を一括管理できます

上記処理の反映には数分~24 時間ほど見ておくと安心です。

Geminiに学習されたデータは最大18ヶ月保存される

Geminiのデフォルト設定だと、入力されたデータは最大18ヶ月保存され、Geminiの学習対象になることがあります。

保存期間は上記画面の右にある矢印をクリックし、3か月・18か月・36か月のいずれかに変更可能です。

アクティビティをオフにすると最大72時間で削除される

もし全見出しの工程でGeminiで入力データをAI学習から除外した場合、それ以降のデータは学習やパーソナライズには使われません。

しかし最大72時間までは一時的に保存され、サービス提供と品質向上(例:フィードバック処理)に利用されます。

この72時間分は、Geminiアプリのアクティビティ履歴には表示されません。

Geminiの学習機能をオフにすることで得られるメリット

GeminiのAI機能をオフにすると、ユーザーのプロンプトや会話内容がAIモデルの再学習素材として Googleに渡らなくなります。

その結果、個人情報や社内の機密資料が第三者レビューの対象になったり、学習済みデータとして社外に再利用されたりするリスクを防止できます。

また、自社ドキュメントやプログラムコード、クリエイティブ作品などを入力しても、その内容がモデルに吸収されにくくなるのもメリットのひとつ。ほかのユーザーが似たプロンプトを投げた際に「そっくりそのまま再出力される」可能性が大幅に低減します。

Geminiの学習機能をオフにすることで生じるデメリットと注意事項

履歴は最長72 時間で消える

GeminiのAI学習機能をオフにすると、チャット内容は「安全確認」用に最大72時間だけGoogleのサーバーに一時保存されます。72時間を過ぎると自動削除されるため、古い会話をあとから呼び出すことはできません。

設定を切り替える前に「残したい会話はコピーしておく」といった対策が必要です。

パーソナライズ機能が弱体化

Geminiの拡張機能やGoogle Maps連携などは、過去ログを参照してAIモデルをチューニングしています。AIの学習機能を無効化するとユーザー履歴という学習素材が減るため、回答の精度が落ちたり一部機能が正しく動作しない可能性があります。

「個人情報を守る代わりに、利便性が下がる」というトレードオフを理解しましょう。

一部のモバイル機能は強制的にログを残す

スマートフォン版のGemini Liveのように、アクセス許可を与えた瞬間にActivityが自動でオンになる機能があります。ユーザー側で完全オフにできないケースもあるため、「Live モードを使うときは必ず履歴が残る」と覚えておくと安心です。

どうしてもログを残したくない場合は、該当機能を利用しない選択肢も検討してください。

Gemini APIは学習に使われない

Gemini APIを通じて送信されたプロンプトやチューニングデータは、Googleの基盤モデル(LLM)のトレーニングや強化には使用されません。つまりユーザーが入力した情報は将来のモデル改善に使われることはなく、安心して利用できるよう設計されています。

Google Cloudの公式ドキュメントでは以下のように明記されています。

Gemini と PaLM 2 の両方のプロンプトとチューニング データが、基盤モデルのトレーニングや強化に使用されることはありません。

【引用元】

Google Cloud「Gemini API に関するよくある質問」:https://cloud.google.com/vertex-ai/generative-ai/docs/multimodal/multimodal-faqs?hl=ja

この方針により企業や開発者は機密性の高いデータを扱う場合でも、Gemini APIを安全に活用できます。GoogleはVertex AI上での生成AI活用において、明確なデータガバナンスとプライバシー保護を約束しています。

ユーザーデータが漏えいするリスクと発生要因

標準モードのままGeminiを使うと、あなたが打ち込んだ質問(プロンプト)や回答の内容に加えて、端末情報や現在地などのメタデータもGoogle側に記録されます。

品質向上のプロセスでは、これらのログが社内スタッフによって目視チェックされることがあり、そのレビュー記録は最長3年間保管される仕組みです。

したがって、社外秘の資料や個人情報をそのまま入力すると、レビュー工程を通じて第三者の目に触れるリスクが残る点に注意が必要です。そのため、機密情報の入力は「本当に必要か?」を考えてから行うことが重要です。

企業・組織がとるべき安全運用ガイドと対策

追加データ保護版 Gemini for Google Workspace を導入する

Googleと締結するエンタープライズ契約には「Workspace内のユーザーデータはAIモデルの学習に使用しない」と明記されています。

- モデル訓練への不利用を保証: ソースコードや設計図などの機密ファイルが、生成 AI のトレーニングコーパスに混ざる心配がありません。

- 管理者による一元設定: サービスの有効/無効やユーザー権限を OU(組織部門)単位で細かく制御でき、アクセスログも管理コンソールから確認可能です。

Conversation history設定とDLPポリシーを組み合わせる

履歴保持を短期間またはオフにしつつ、Data Loss Prevention(DLP)で漏えいを自動ブロックする二重の守りを構築します。

- 履歴保持を「72 時間以内」か「保存しない」に設定: 残存リスクを最小化。

- DLP ルールで機密語句をマスキング: 「顧客番号」「財務データ」などトリガー語を検出したら自動的に伏字や送信拒否に。

- アラートと監査ログ: DLP が発動した際に管理者へ通知し、後からユーザー行動をトレースできるようにしておきます。

社内ガイドラインと従業員教育を徹底する

技術面のガードに加え、ヒューマンエラーを減らす運用ルールが不可欠です。

- 入力前チェックリスト: 「機密データを含むか」「匿名化タグを付けたか」など、プロンプト送信前に確認すべき項目を明文化。

- 誤入力時の対応フロー: 誰に、どのチャネルで、どのタイミングで報告するかを手順化し、迅速なログ削除や権限停止に備えます。

- 定期研修とテスト: AI 利用ポリシーやセキュリティ対策を e-learning と小テストで年に1〜2回アップデート。習熟度の低いユーザーには再受講を義務づけることで、運用ルールの“形骸化”を防ぎます。

これら技術的ガード(AI 設定+DLP)と人的ガード(ポリシー+教育)の二層構えが、組織のデータを守りつつGeminiを安全に活用する最短ルートです。

コメント